首页 > 快讯 2024将至,生成式AI新一年有哪些趋势值得关注

2024将至,生成式AI新一年有哪些趋势值得关注

如果二十年后我们回头审视今天,我们一定会认为2023年前后是人类历史上一个具有里程碑式的一年,而且是在各个领域都有跨时代里程碑式的标志在这两年中出现。在科技领域,这个里程碑式的标志就是生成式AI的崛起。

从去年年底,ChatGPT横空出世,2023年就被业内视为生成式AI的元年。在今年,涉及各行各业的生成式AI的各种模型、应用层出不穷。而在即将进入的2024年,就将是生成式AI大规模得到应用的一年。对于一些头部企业,从元年到进入大规模应用的新年,需要考虑的问题和遇到的问题无疑会有很大不同。这就是最近戴尔科技对2024年展望中涉及的主题。

从训练阶段到推理阶段的转变

2024年,生成式AI仍然是一个火热的话题。在2023年中,Google、OpenAI、阿里巴巴等互联网巨头都陆续推出了自己的生成式AI技术产品,但是还没有多少客户把生成式AI系统投入到实用中。而且全世界范围内尚没有哪个大型企业在做自己的大模型,这些参与到生成式AI大战的企业都是在使用世界各地它们能获得的基础模型,然后对这些基础模型进行调优或者互联。

这是基于非常现实的成本考虑,大语言模型的训练成本是高昂的,但是垂直行业的企业不会直接在企业的应用中来用这些模型。所以,对企业最有利的选择是进一步开发各种基础模型,让这些模型在投入到垂直行业的生产当中的时候,再向模型输入各种各样的数据。在使用聊天机器人Chatbot或者是代码开发的过程中,才能够让这些模型真正地产生生产力。

对于这些企业来说,在进入2024年之后,对于生成式AI的工作重心会从2023年的训练转换成2024年的推理。戴尔科技集团全球首席技术官John Roese认为,这些企业应当考虑三个问题:1)推理的基础架构是什么?2)应该把推理放在什么地方?3)如何来确保推理基础架构的安全?

在训练阶段,企业更需要大型的集群和加速的计算架构,但到了推理阶段则不然,企业这时候需要的基础架构主要取决于有多少用户来使用模型的推理能力。如果企业有非常成熟的模型但只有很少量的用户,一台服务器可能就足够了。反之有一个非常简单的模型,但客户非常多,则可能需要几十万台服务器来组成基础架构。

在训练阶段,大模型的训练是在数据中心当中进行的,因为数据中心有大量的加速器。但是推理则要放在数据和用户所在的地方,所以,一般来说推理不会被放在数据中心当中,更有可能会放在边缘当中,必须要接近呼叫中心或者是客户所在的位置。

这就引出了前述第三个问题,如何来确保推理基础架构的安全?训练基础架构保护好自己的数据中心就够了,但如果把推理的基础架构部署到离开数据中心更远更分散的边缘中,来到了工厂、制造中心和客户所在的地方,包括交通运输的网络中,这需要的安全保护模式就很不一样,有不同类型的风险、不同类型的攻击。事实上,黑客已经开始侵入到了边缘基础架构当中,把已经投入生产阶段的训练模型提取出来做反向工程设计进行模仿,这样的攻击已经实实在在发生了。

企业更需要考虑大模型的运营成本

从戴尔科技的经验来看,在生成式AI大模型显示出强大的能力和无限可能的时候,这些大型企业各个部门都表现出强大的兴趣,纷纷提出自己的AI创新项目。比如戴尔科技就收到数百个提交的生成式AI项目。但通常一个企业的资源始终是有限,只能选择其中的几个来重点实施,减少风险,并让经济效益最大化。

在训练阶段,企业投入到生成式AI的成本基本都是训练成本,而进入2024年后,随着企业开始使用这些科技,成本则将会从训练的成本到运营的成本的转变。

零信任是未来安全的必要选择

零信任的概念并非新事物,已经在业内存在很多年。但普遍来说,现行的主流安全架构仍然是反应型或被动型的架构,这就意味着只有在出现问题之后,企业才会有解决方式。但在AI时代,这样的安全防护已经远远不够了。由于生成式AI大大降低了黑客的技术门槛,并增加了攻击频率和隐蔽性,现在主流的安全模型对于黑客的反应已经略显落伍。

在新形势下,零信任就显得非常必要。对零信任而言,企业首先需要识别什么是好的,什么行为是允许的,除此之外要阻止所有的接入。同时,零信任也是完全的、验证的环境,要对它好的行为进行描述,一旦出现威胁的情况下,可以实时来解决。

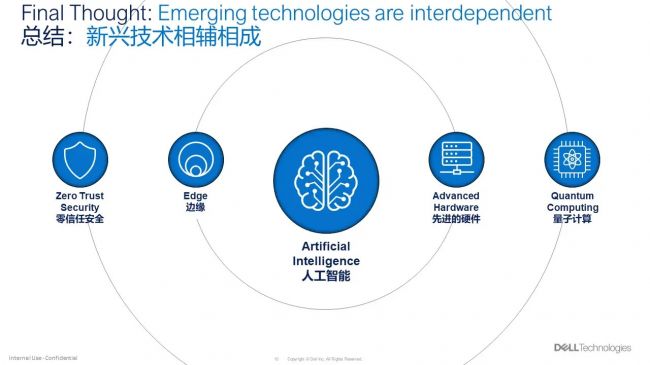

每一次科技的飞跃都是社会生产和商业模式的更新换代,更具有强智能的AI崛起已经为人类开启了新的未来。2024年,行业中会有方方面面、各种各样的技术通过互联互通相辅相成。企业必须未雨绸缪才能在层出不穷的新技术迭代中不被动,不被时代甩在身后。

责任编辑:

文章来源:http://www.anfangnews.com/2023/1219/10341.shtml